Joe Lauria (CONSORTIUM NEWX) 13 de enero de 2025

La inteligencia artificial parece destinada a cambiar el mundo, pero primero debe ponerse las pilas o se desatará un infierno, escribe uno de los dos «Joe Laurias».

No hay forma de revertir el surgimiento de la Inteligencia Artificial, que está camino de dominar nuestras vidas. Desde el servicio al cliente hasta la censura y la guerra, la IA está dejando su huella y el potencial de desastre es real.

La cantidad de contacto cara a cara, o incluso la interacción humana de voz a voz por teléfono cuando se hacen negocios, ha ido disminuyendo durante años y está empeorando con la IA. Pero la IA está haciendo mucho más que erosionar la comunidad, destruir empleos y debilitar a las personas que esperan en línea.

La IA está cada vez más detrás de las decisiones que toman las empresas de redes sociales sobre qué publicaciones eliminar porque violan algunos estándares vagos de la “comunidad” (ya que destruyen la comunidad), cuando es obvio que la IA está programada para eliminar los mensajes políticos disidentes.

La IA también toma decisiones sobre a quién suspender o prohibir en un sitio de redes sociales, y también parece evaluar las “apelaciones” a las suspensiones, que en muchos casos serían revocadas si solo se aplicaran un par de ojos humanos.

El fundador de Facebook, Mark Zuckerberg, admitió esta semana que “construimos muchos sistemas complejos para moderar el contenido, pero el problema con los sistemas complejos es que cometen errores”. Facebook admite que utilizó sistemas de inteligencia artificial para eliminar publicaciones de los usuarios.

“Incluso si censuran accidentalmente solo el 1% de las publicaciones, eso significa millones de personas, y hemos llegado a un punto en el que hay demasiados errores y demasiada censura”, dijo Zuckerberg.

Los absurdos extremos a los que se está aplicando la IA incluyen un “think tank” en Washington que está totalmente dirigido por la Inteligencia Artificial. Drop Site News informa sobre el Beltway Grid Policy Center que no tiene dirección de oficina.

“La falta de presencia física de Beltway Grid en Washington —o en cualquier otro lugar del plano terrestre de la existencia— se debe a algo más que una generosa política de trabajo desde casa. La organización no parece exigir a sus empleados que existan en absoluto”, escribe el sitio. Sin embargo, produzca una gran cantidad de informes, comunicados de prensa y presentaciones a los periodistas.

Si bien este puede ser un uso extremo de la IA, la interacción más habitual con el público está plagada de otro problema: cuán equivocada puede estar la IA.

Todavía bastante experimental.

La IA está claramente en una etapa experimental y, aunque es inevitable que se cometan errores importantes, estos no han frenado su aplicación. Los errores van desde lo mundano hasta lo ridículo y lo peligroso.

Recientemente descubrí un ejemplo de lo ridículo.

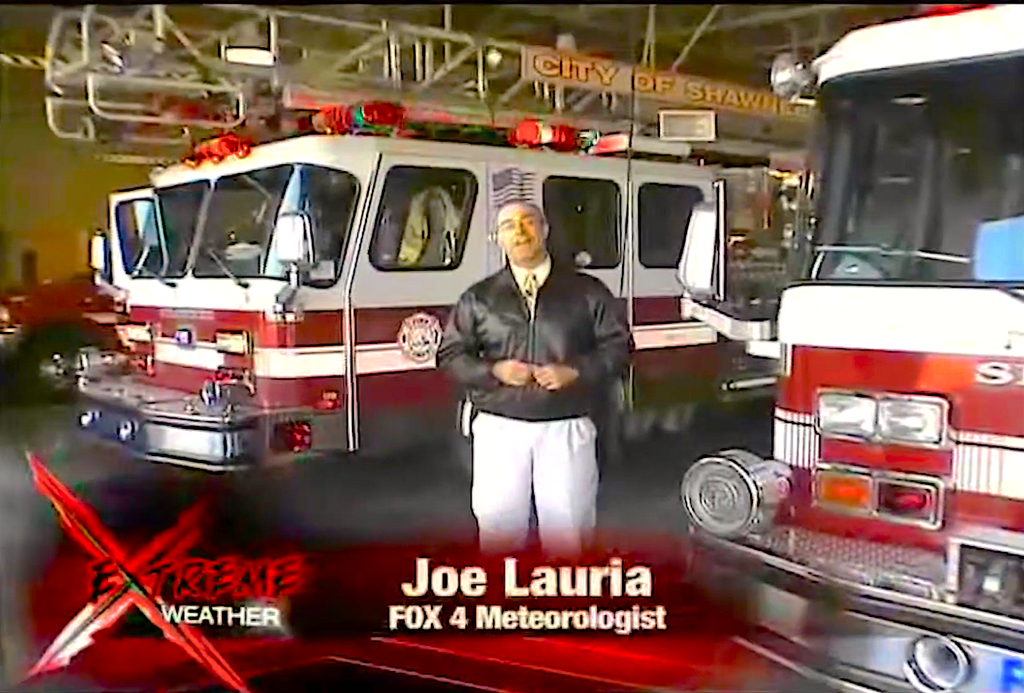

Cualquiera que busque en Google su perfil en línea seguramente encontrará a otras personas con su mismo nombre. Hace tiempo que conozco a Joe Lauria, un meteorólogo de la cadena Fox en Kansas City, Missouri.

Ya hemos estado confundidos antes. Hace apenas dos semanas, recibí un correo electrónico de un espectador de Fox en el área de Kansas City que elogiaba a Lauria por estar tan bien vestida y me pidió consejo sobre dónde comprar un traje. Tenía curiosidad por saber quién más podría estar confundido, así que le preguntó a Grok, el tan promocionado sistema de inteligencia artificial de Elon Musk, quién era Joe Lauria.

Esta es la respuesta que recibí:

“Joe Lauria es un profesional polifacético conocido principalmente por su trabajo en periodismo y meteorología. A continuación, se presenta un resumen de su carrera según la información disponible:

- Periodismo: Joe Lauria ha sido periodista de asuntos exteriores en las Naciones Unidas desde 1990. Ha colaborado con numerosas publicaciones, entre ellas el Boston Globe, el London Daily Telegraph, el Johannesburg Star, el Montreal Gazette, el Wall Street Journal, el New York. Times, el Washington Post, Salon.com y The Guardian.

- También ha sido periodista de investigación para The Sunday Times de Londres y Bloomberg News. Actualmente, Lauria es el editor jefe de Consortium News, donde escribe sobre asuntos internacionales, con especial atención al Oriente Medio. Ha escrito libros en coautoría con figuras destacadas, como el ex senador estadounidense Mike Gravel, centrados en la política exterior y el militarismo de Estados Unidos.

- Meteorología: Joe Lauria es un meteorólogo galardonado. Trabaja como meteorólogo de noticias vespertinas para FOX4 en Kansas City desde enero de 1995 y transmite pronósticos meteorológicos todos los días de la semana a las 5, 6, 9 y 10 pm Su enfoque en la meteorología incluye educar a los espectadores sobre aspectos del clima que no se encuentran comúnmente en las aplicaciones meteorológicas estándar.

- Antes de su puesto en FOX4, fue compañero como meteorólogo jefe en KOSA-TV en Midland, Texas, y trabajó en varios otros lugares como Orlando, Florida, y Kansas City, Missouri. Su trabajo ha sido reconocido al recibir el Sello de Aprobación tanto de la Sociedad Meteorológica Estadounidense (AMS) como de la Asociación Meteorológica Nacional (NWA). Lauria también posee la designación de Meteorólogo Certificado en Radiodifusión (CBM) de la AMS.

- Vida personal: Joe Lauria nació en New Rochelle, Nueva York, y actualmente reside en Olathe, Kansas, con su esposa, Jaye Lynn, y sus dos gatos. Le gustan los restaurantes italianos, el golf y ha participado en servicios comunitarios a través de seminarios y discursos sobre el clima.

La doble carrera de Joe Lauria en periodismo y meteorología resalta sus diversos intereses y contribuciones a la comprensión y seguridad públicas a través de informes meteorológicos e informes perspicaces sobre asuntos internacionales”.

Solo para que conste, no tengo gatos, no juego al golf y no nací en New Rochelle (pero no tan lejos, en el Bronx). Por supuesto, hay mucho humor en esto. (También es gracioso que entró a la universidad sin decidir si quería ser periodista o meteoróloga. Luego vi cuántas matemáticas hay involucradas en la meteorología).

Sin embargo, la posibilidad de que se produzcan cuentos dispares en un sistema que parece estar apoderándose gradualmente del mundo no siempre es motivo de risa. Es preocupante que la inteligencia artificial de Grok diera por sentado que dos personas son una, en lugar de admitir simplemente que hay varias personas con el mismo nombre.

Por otra parte, Chat GPT hizo una disertación impresionante, incisiva y políticamente neutral sobre mi trabajo en respuesta a la pregunta «¿Quién es Joe Lauria?». Fue casi como si lo hubiera contratado para que fuera mi agente de relaciones públicas. El ensayo suena como si Chat GPT hubiera pasado meses leyendo todo lo que había escrito, cuando fue generado en segundos. Tampoco había señales del meteorólogo de Kansas City.

Sin embargo, cuando hurgué un poco más en su “conocimiento” de mí, se inventó cosas de la nada. Cuando le pregunté qué libros había escrito, en lugar de nombrar los libros que realmente escribí, me dio un título completamente ficticio de un supuesto libro de no ficción: The Assange Agenda: The Legacy of the Wikileaks Founder. Incluso supuso que se trataba de una editorial: Clarity Press.

No existe tal libro. Basándose en su conocimiento de mis artículos sobre Julian Assange, hizo una conjetura ridícula sobre un libro imaginario que creyó que yo había escrito. En resumen, gran parte de la inteligencia artificial es una tontería.

IA y guerra

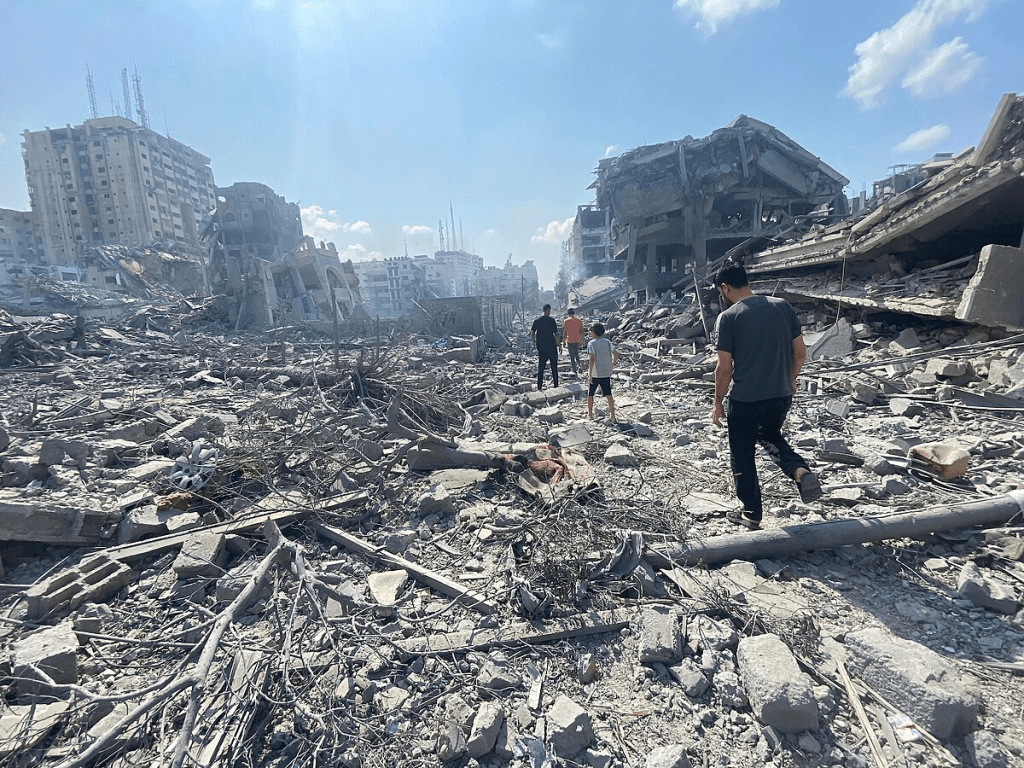

Los daños en Gaza. (Naamán Omar\Agencia Palestina de Noticias e Información, Wafa, para APAimages, Wikimedia Commons, CC BY-SA 3.0)

Por ridículos que sean estos resultados, por frustrantes que se estén volviendo las interacciones sin humanos en el servicio al cliente (como las atractivas publicaciones en las redes sociales eliminadas por la IA) y por muchos empleos que se estén perdiendo debido a la IA, la preocupación más angustiosa sobre la Inteligencia Artificial es su uso en la conducción de la guerra.

En otras palabras, ¿qué sucede cuando los errores de la IA pasan de ser algo inofensivo y cómico a ser cuestiones de vida o muerte?

La revista Time informó en diciembre sobre el uso de inteligencia artificial por parte de Israel para matar civiles en su genocidio en Gaza:

“Un programa conocido como ‘El Evangelio’ genera sugerencias sobre edificios y estructuras en los que pueden estar operando militantes. ‘Lavender’ está programada para identificar a presuntos miembros de Hamás y otros grupos armados para asesinarlos, desde comandantes hasta soldados rasos. ‘¿Dónde está papá?’ al parecer sigue sus movimientos rastreando sus teléfonos para atacarlos, a menudo hasta sus casas, donde su presencia se considera una confirmación de su identidad. El ataque aéreo que sigue podría matar a todos los miembros de la familia del objetivo, si no a todos los que viven en el edificio de apartamentos.

Estos programas, que la Fuerza de Defensa de Israel (FDI) ha reconocido estar desarrollando, pueden ayudar a explicar el ritmo de la campaña de bombardeos más devastadora del siglo XXI…”

La revista israelí +972 y The Guardian dieron la noticia en abril, informando que la IA había seleccionado hasta 37.000 objetivos (la cifra debería ser mucho mayor desde abril), agilizando un proceso que antes implicaba análisis humano y una autorización legal antes de poder lanzar. una bomba.

Lavender empezó a recibir presiones intensas para que lanzara cada vez más bombas sobre Gaza. The Guardian informó:

“Nos presionamos constantemente: ‘Traednos más objetivos’. Realmente nos gritaban”, dijo un oficial de inteligencia [israelí]. “Nos decían: ahora tenemos que joder a Hamás, sin importar el costo. Todo lo que podéis, lo bombardeáis”.

Para satisfacer esta demanda, las FDI recurrieron en gran medida a Lavender para generar una base de datos de individuos que se consideraba que tenían características de militantes de la PIJ [Yihad Islámica Palestina] o de Hamás. […]

Después de tomar muestras al azar y verificar sus predicciones, la unidad concluyó que Lavender había logrado una tasa de precisión del 90%, dijeron las fuentes, lo que llevó a las FDI a aprobar su uso generalizado como herramienta de recomendación de objetivos.

Lavender creó una base de datos de decenas de millas de personas que fueron marcadas como miembros predominantemente de bajo rango del ala militar de Hamas”.

El noventa por ciento no es una evaluación independiente de su precisión, sino la propia evaluación de las FDI. Incluso si la utilizáramos, significaría que de cada 100 personas a las que Israel ataca con este sistema, al menos 10 son completamente inocentes, según su propia admisión.

Pero no estamos hablando de 100 personas atacadas, sino de “decenas de millas”. Hagan los cálculos: de cada 10.000 personas atacadas, 1.000 son víctimas inocentes, que podrían ser asesinadas por las FDI.

En abril del año pasado, Israel admitió en esencia que 3.700 habitantes de Gaza habían sido asesinados por sus aliados israelíes. Eso fue hace ocho meses. ¿Cuántos más han sido asesinados?

El periódico nacional de Abu Dhabi informó :

“Los expertos en tecnología han advertido al ejército de Israel sobre un posible ‘error de sesgo extremo’ al confiar en el Big Data para atacar a la gente enGaza mientras se utilizan programas de inteligencia artificial. […]

El uso por parte de Israel de poderosos sistemas de inteligencia artificial ha llevado a su ejército a ingresar a territorio para una guerra avanzada nunca antes vista a tal escala entre soldados y máquinas.

Según informes no verificados, los sistemas de IA tenían «un error de sesgo extremo, tanto en los datos de orientación que se utilizan como en la acción cinética», dijo Hammond-Errey en respuesta a una pregunta de The National . El error de sesgo extremo puede ocurrir cuando un dispositivo está calibrado incorrectamente, por lo que calcula mal las mediciones.

El experto en inteligencia artificial y director de tecnología emergente de la Universidad de Sydney sugirió que los amplios conjuntos de datos «que son altamente personales y comerciales» significan que las fuerzas armadas «en realidad no tienen la capacidad de verificar» los objetivos y que esos era potencialmente «un factor que contribuye a errores tan grandes».

Ella dijo que tomará “mucho tiempo para que podamos realmente tener acceso a esta información”, si es que alguna vez lo logramos, “para evaluar algunas de las realidades técnicas de la situación”, mientras continúan los combates en Gaza.

Seguramente la inteligencia artificial de las FDI debe ser más sofisticada que las versiones de inteligencia artificial disponibles comercialmente para el público en general, como Grok o ChatGPT. Y, sin embargo, las IED admiten que hay al menos un 10 por ciento de error cuando se trata de decidir quién debe vivir y quién debe morir.

Por si sirve de algo, ChatGPT, uno de los más populares, dice que los peligros de los errores en el sistema Lavender son:

- “Sesgo en los datos : si Lavender se entrena con datos que provienen desproporcionadamente de ciertas fuentes, podría conducir a resultados sesgados, como la identificación incorrecta del comportamiento de grupos específicos o la evaluación incorrecta de ciertos tipos de señales.

- Conjuntos de datos incompletos o sesgados : si los datos utilizados para el entrenamiento están incompletos o no cubren una amplia gama de amenazas potenciales, la IA puede pasar por altas señales críticas o malinterpretar actividades inocuas como amenazas ”. (énfasis añadido)

IA y armas nucleares

Un proyecto de ley del Senado de Estados Unidos prohibiría la participación de la inteligencia artificial en armas nucleares. (Guardia Nacional del Ejército de Estados Unidos, Ashley Goodwin, dominio público)

La preocupación de que los errores de la Inteligencia Artificial puedan conducir a un desastre nuclear se refleja en el proyecto de ley S. 1394 del Senado de Estados Unidos , titulado Ley de Bloqueo de Lanzamiento Nuclear por Inteligencia Artificial Autónoma de 2023. El proyecto de ley

“prohíbe el uso de fondos federales para un sistema de armas autónomo que no esté sujeto a un control humano significativo para lanzar un arma nuclear o para seleccionar o atacar objetivos con el propósito de lanzar un arma nuclear.

Con respecto a un sistema de armas autónomo, un control humano significativamente significa el control humano de (1) la selección y ataque a los objetivos; y (2) el tiempo, la ubicación y la forma de uso”.

El proyecto de ley no salió del Comité de Servicios Armados del Senado, pero la OTAN se burló de él. Un artículo publicado en NATO Review el pasado mes de abril se quejaba de que:

“Parece que estamos en vías de desarrollar rápidamente un marco diplomático y regulatorio que restrinja la IA en los sistemas de armas nucleares. Esto es preocupante por al menos dos razones:

- La IA tiene una utilidad que permitirá fortalecer la disuasión nuclear sin necesariamente ampliar el arsenal nuclear.

- La prisa por prohibir la IA en las defensas nucleares parece tener su raíz en un malentendido sobre el estado actual de la IA, un malentendido que parece estar más informado por la ficción popular que por la ciencia popular”. […]

“El tipo de inteligencia artificial que existe hoy en día no es IAG. Puede pasar la prueba de Turing (es decir, puede ser indistinguible de un ser humano al responder las preguntas planteadas por un usuario), pero no es capaz de pensar de forma independiente y, desde luego, no es consciente de sí misma”.

En esencia, la OTAN dice que, como la IA no es capaz de pensar por sí misma, no hay nada de qué preocuparse. Sin embargo, los seres humanos muy inteligentes que son capaces de pensar por sí mismos cometen errores, y más aún una máquina que depende de la intervención humana.

El documento sostiene que la IA mejorará inevitablemente la precisión de los objetivos nucleares. En ningún lugar del documento se encuentran las palabras “error” o “equivocación” en singular o plural.

Grok combinó dos Laurias en una. Hay 47 centros de población en los Estados Unidos con el nombre de Moscú. Sólo lo digo. (Lo sé, las coordenadas son todas diferentes).

Pero el artículo de la OTAN no quiere una discusión diplomática y se queja de que “la cuestión incluso se planteó en las discusiones entre Estados Unidos y China en el foro de Cooperación Económica Asia-Pacífico, que se reunió en San Francisco en noviembre (de 2023)”.

El documento concluyó: “Teniendo en cuenta los posibles beneficios geopolíticos que se pueden obtener, prohibir la IA en las defensas nucleares es una mala idea”.

En un mundo sensato volveríamos a las interacciones puramente humanas en nuestra vida cotidiana y, si no se puede evitar la guerra, al menos volveríamos a tomar decisiones humanas más minuciosas sobre a quién atacar.

Como nada de esto va a suceder, más vale que esperemos que la IA mejore muchísimos para que la comedia no se convierta en tragedia, o peor aún, en una catástrofe total.

Joe Lauria es redactor jefe de Consortium News y ex corresponsal en la ONU de The Wall Street Journal, Boston Globe y otros periódicos, entre ellos The Montreal Gazette, London Daily Mail y The Star of Johannesburg. Fue periodista de investigación para el Sunday Times de Londres, periodista financiero de Bloomberg News y comenzó su trabajo profesional a los 19 años como corresponsal de The New York Times. Es autor de dos libros, A Political Odyssey , con el senador Mike Gravel, prólogo de Daniel Ellsberg; y Cómo perdí, de Hillary Clinton , prólogo de Julian Assange.

Deja un comentario