Los oficiales militares estadounidenses pueden aprobar el uso de tecnologías militares mejoradas con IA en las que no confían. Ése es un problema grave.

Este artículo de un teniente coronel de EEUU pone de manifiesto los terribles riesgos que se ponen en manos de militares respecto del manejo de las mismas en guerras actuales y futuras. Como vimos en las guerras del golfo, Afganistán y, ahora, en Gaza, la utilización de la tecnología no impide, sino todo lo contrario, las matanzas de civiles. La conclusión optimista de Paul Lushenko no se atiene a los hechos que vemos cada día. Igual que se reguló y limitó el uso de armas nucleares, es imprescindible su limitación, antes de que sea demasiado tarde. (Gerardo Del Val. Gaceta Crítica. 30 de Noviembre de 2023)

Por Paul Lushenko

29 de noviembre de 2023

Los expertos coinciden en que la guerra futura se caracterizará por el uso de tecnologías mejoradas con inteligencia artificial (IA), especialmente sistemas de armas totalmente autónomos. Estas capacidades, como el vehículo aéreo no tripulado o drone “ Loyal Wingman ” de la Fuerza Aérea de EE. UU., pueden identificar, rastrear y procesar objetivos sin supervisión humana. El reciente uso de estos letales sistemas de armas autónomas en conflictos (incluidos los de Gaza , Libia , Nagorno-Karabaj y Ucrania ) plantea importantes cuestiones jurídicas , éticas y morales .

A pesar de su uso, todavía no está claro cómo las tecnologías militares mejoradas con IA pueden cambiar la naturaleza y la dinámica de la guerra. Los más preocupados por el uso de la IA con fines militares prevén un futuro distópico o “apocalipsis de la IA”, en el que las máquinas madurarán lo suficiente como para dominar el mundo. Un analista político incluso predice que los sistemas de armas letales autónomas “conducirán a un cambio sísmico en el orden mundial mucho mayor que el que ocurrió con la introducción de las armas nucleares”. Otros observadores cuestionan hasta qué punto los sistemas de IA podrían de manera realista controlar a los humanos, dada la complejidad de modelar la inteligencia biológica a través de algoritmos. Suponiendo que tal extensión de la IA sea posible, los ejércitos que dependen de ella se ven afectados por costos de datos y juicios que posiblemente «hacen que el elemento humano en la guerra sea aún más importante, no menos».

Si bien son útiles para discutir los efectos potenciales de la IA en la política global , estas perspectivas no explican cómo la IA puede realmente alterar la conducción de la guerra ni qué piensan los soldados sobre este tema. Para abordar este problema, recientemente investigué cómo las tecnologías militares mejoradas con IA (integradas en varios niveles de toma de decisiones y tipos de supervisión) moldean la confianza de los oficiales militares estadounidenses en estos sistemas, lo que informa su comprensión de la trayectoria de la guerra. En el campo de la IA, la confianza se define como la creencia de que una tecnología autónoma funcionará de manera confiable como se espera en la consecución de objetivos compartidos.

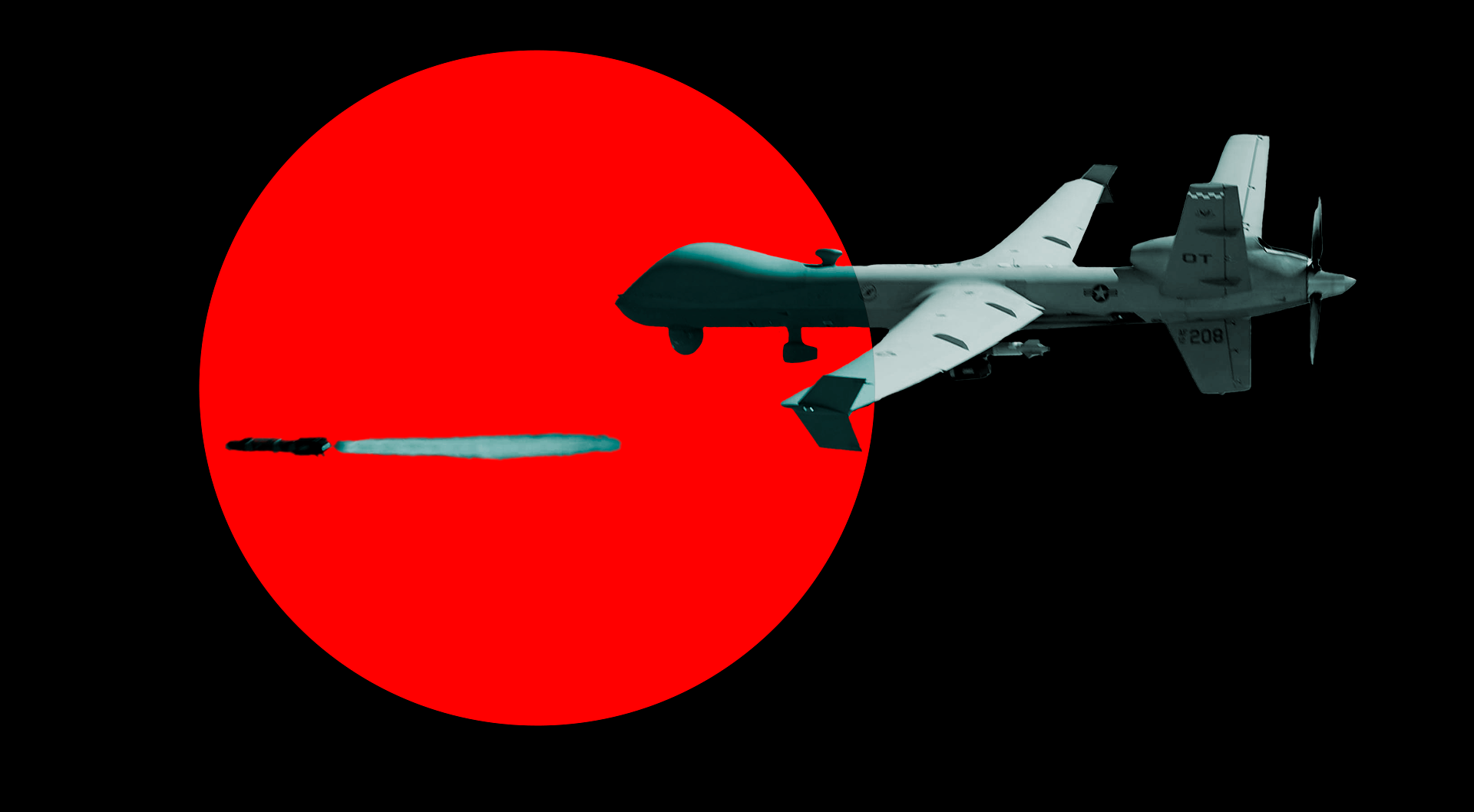

El vehículo aéreo de combate sin piloto XQ-58A Valkyrie, «compañero leal», que se ve aquí desplegando un pequeño sistema de avión no tripulado Altius-600, está impulsado por inteligencia artificial y puede identificar, rastrear y procesar objetivos sin supervisión humana. (Foto: Fuerza Aérea de EE.UU. Diseño: François Diaz-Maurin/Erik English)

Para medir el nivel de confianza de los militares en los sistemas de armas letales autónomas, estudié las actitudes de los oficiales que asistían a la Escuela de Guerra del Ejército de los EE. UU. en Carlisle, Pensilvania, y a la Escuela de Guerra Naval de los EE. UU. en Newport, Rhode Island. Estos oficiales, de cuyas filas el ejército sacará a sus futuros generales y almirantes, son responsables de gestionar la integración y el uso de capacidades emergentes durante futuros conflictos. Por lo tanto, sus actitudes son importantes para comprender hasta qué punto la IA puede dar forma a una nueva era de guerra librada por ejércitos de «robots de guerra».

Mi investigación muestra tres hallazgos clave. En primer lugar, los oficiales confían de manera diferente en las tecnologías militares mejoradas con IA según el nivel de toma de decisiones en el que se integran y el tipo de supervisión de las nuevas capacidades. En segundo lugar, los oficiales pueden aprobar o apoyar la adopción de tecnologías militares mejoradas con IA, pero no confiar en ellas, lo que demuestra una desalineación de actitudes que tiene implicaciones para la modernización militar. En tercer lugar, las actitudes de los oficiales hacia las capacidades habilitadas por la IA también pueden estar determinadas por otros factores, incluidas sus creencias morales, la preocupación por una carrera armamentista de la IA y el nivel de educación. En conjunto, estos hallazgos proporcionan la primera evidencia experimental de actitudes militares hacia la IA en la guerra, que tienen implicaciones para la modernización militar, la supervisión de políticas de armas autónomas y la educación militar profesional, incluido el mando y control nuclear.

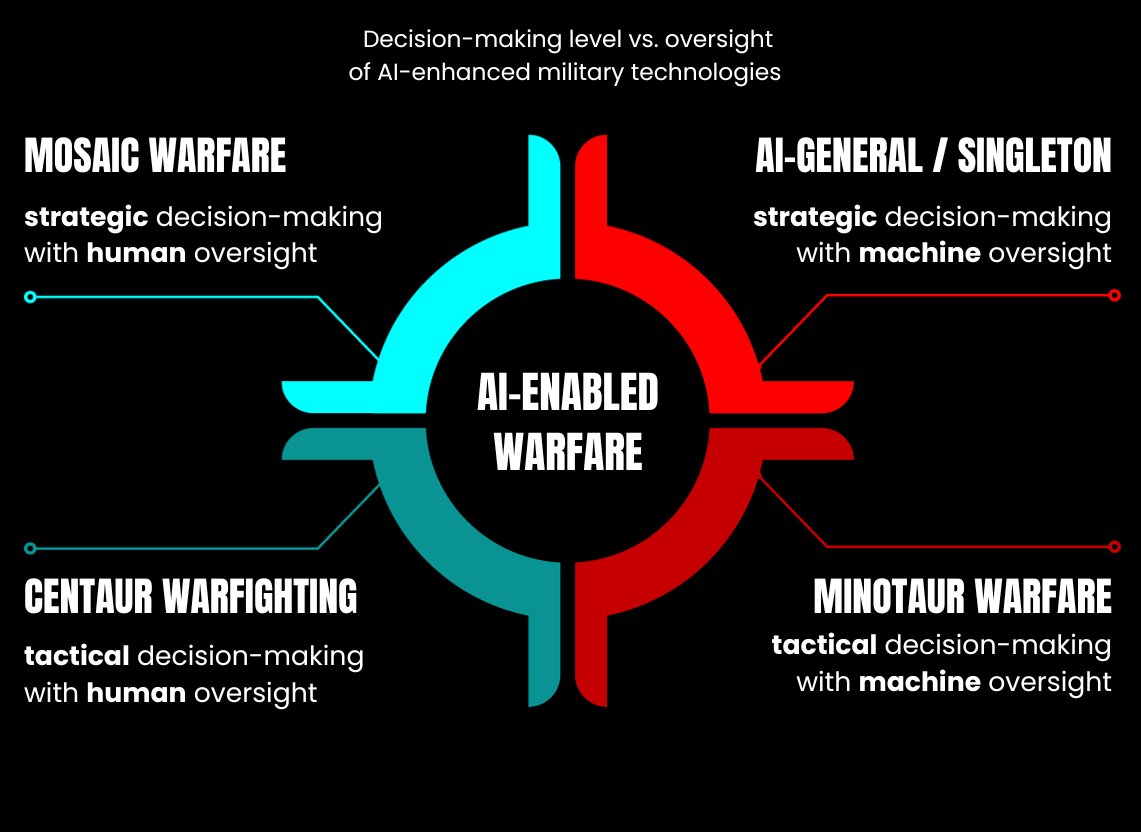

Cuatro tipos de guerra basada en IA

La adopción de tecnologías militares mejoradas con IA por parte de diferentes países puede variar en términos del nivel de toma de decisiones (táctica o estratégica) y el tipo de supervisión (humana o mecánica). Los países pueden optimizar algoritmos para realizar operaciones tácticas en el campo de batalla o llevar a cabo deliberaciones estratégicas en apoyo de los objetivos generales de la guerra. Tácticamente, estas tecnologías pueden mejorar la letalidad de los comandantes de campo al analizar rápidamente grandes cantidades de datos extraídos de sensores distribuidos en el campo de batalla para generar opciones de selección de objetivos más rápido que los adversarios. Como lo expresa el experto en ciberseguridad Jon Lindsay , “el combate podría modelarse como un juego que se gana destruyendo más enemigos y preservando más aliados”. Esto se logra acortando significativamente el tiempo del “ sensor al tirador ”, que corresponde al intervalo de tiempo entre la adquisición y el procesamiento de un objetivo. El Grupo de Trabajo Lima del Departamento de Defensa de EE. UU. y el Proyecto Maven son ejemplos de este tipo de aplicaciones de IA.

Estratégicamente, las tecnologías militares mejoradas por IA también pueden ayudar a los líderes políticos y militares a sincronizar objetivos (fines) clave con una combinación de enfoques de guerra (formas) y recursos finitos (medios), incluidos material y personal. Incluso podrían surgir nuevas capacidades que reemplacen a los humanos en futuras operaciones militares, incluso para diseñar direcciones estratégicas y estrategias a nivel nacional. Como sostiene un experto , la IA ya ha demostrado su potencial “para participar en análisis y estrategias complejos comparables a los necesarios para hacer la guerra”.

Al mismo tiempo, los países también pueden calibrar el tipo de supervisión o control delegado a las tecnologías militares mejoradas con IA. Estas tecnologías pueden diseñarse para permitir una mayor supervisión humana, lo que permitirá una mayor capacidad de acción en la toma de decisiones. Estos sistemas suelen denominarse semiautónomos, lo que significa que permanecen bajo control humano . Este patrón de supervisión caracteriza cómo operan actualmente la mayoría de los sistemas de armas mejorados por IA, como el dron MQ-9 Reaper de General Atomics. Si bien el Reaper puede volar con piloto automático, teniendo en cuenta los cambios en la topografía y las condiciones climáticas para ajustar su altitud y velocidad, los humanos aún toman las decisiones sobre los objetivos.

Los países también pueden diseñar tecnologías militares mejoradas con IA con menos supervisión humana. A estos sistemas se les suele denominar “robots asesinos” porque el ser humano está fuera del circuito . En estas aplicaciones, los humanos ejercen una supervisión limitada o nula, incluso para las decisiones sobre objetivos. La variación en el nivel de toma de decisiones y el tipo de supervisión sugiere cuatro tipos de guerra que podrían surgir a nivel mundial dada la adopción de tecnologías militares mejoradas con IA.

Los cuatro tipos de guerra basada en IA. (Ilustración: François Díaz-Maurin)

En primer lugar, los países podrían utilizar tecnologías militares mejoradas con IA para la toma de decisiones tácticas con supervisión humana . Esto define lo que Paul Scharre llama “ lucha de centauro ”, que lleva el nombre de una criatura de la mitología griega con la parte superior del cuerpo de un humano y la parte inferior y patas de un caballo. La guerra de centauros enfatiza el control humano de las máquinas con fines en el campo de batalla, como la destrucción de un objetivo, como el alijo de armas de un enemigo.

En segundo lugar, los países podrían utilizar tecnologías militares mejoradas con IA para la toma de decisiones tácticas con supervisión mecánica . Esto pone de cabeza a la guerra de centauros, literalmente, evocando otra criatura mítica de la antigua Grecia: el minotauro, con cabeza y cola de toro y cuerpo de hombre. La “ guerra del Minotauro ” se caracteriza por el control mecánico de los humanos durante el combate y en todos los dominios, que puede variar desde patrullas de soldados en tierra hasta constelaciones de buques de guerra en el océano y formaciones de aviones de combate en el aire.

En tercer lugar, la toma de decisiones estratégicas , junto con la supervisión de las máquinas , encuadra un tipo de guerra “ IA-general ” o “ única ”. Este enfoque confiere a las tecnologías militares mejoradas por IA una libertad extraordinaria para dar forma a la trayectoria de los combates de los países, pero puede tener graves implicaciones para el equilibrio ofensivo-defensivo entre los países durante el conflicto. En otras palabras, un tipo de guerra de IA general podría permitir a los países obtener y mantener ventajas sobre los adversarios en el tiempo y el espacio que dan forma a los resultados generales de la guerra.

Finalmente, la “ guerra en mosaico ” mantiene la supervisión humana de las tecnologías militares mejoradas por IA, pero intenta capitalizar algoritmos para optimizar la toma de decisiones estratégicas para imponer y explotar vulnerabilidades contra un adversario. La intención de este modelo de guerra, que el general (retirado) del Cuerpo de Marines de los EE. UU. John Allen llama “ hiperguerra ” y que los académicos a menudo denominan sistemas algorítmicos de apoyo a las decisiones , es retener la supervisión humana general mientras se utilizan algoritmos para realizar tareas habilitantes críticas. Estos incluyen predecir posibles cursos de acción del enemigo a través de un proceso de “ pronóstico de amenazas en tiempo real ” (que es la misión del nuevo Sistema de Repositorio Rápido Analítico Asistido por Máquinas o MARS , por sus siglas en inglés) del Departamento de Defensa, identificar los más factibles, aceptables y y una estrategia adecuada (que empresas como Palantir y Scale AI están estudiando cómo hacer), y adaptar funciones bélicas clave, como la logística , para ayudar a los militares a ganar y mantener la iniciativa en entornos operativos disputados que se caracterizan por líneas de suministro extendidas, como como el Indo-Pacífico.

Actitudes de los oficiales estadounidenses hacia la guerra basada en IA

Para abordar cómo los oficiales militares confían en las tecnologías militares mejoradas con IA dada la variación en su nivel de toma de decisiones y el tipo de supervisión, realicé una encuesta en octubre de 2023 entre oficiales asignados a las escuelas de guerra en Carlisle y Newport. La encuesta involucró a cuatro grupos experimentales que variaron el uso de una tecnología militar mejorada con IA en términos de toma de decisiones (tácticas o estratégicas) y supervisión (humana o máquina), así como un grupo de referencia que no manipuló estos atributos. Después de leer los escenarios asignados al azar, pedí a los encuestados que calificaran su confianza y apoyo en la capacidad en una escala del uno (bajo) al cinco (alto). Luego analicé los datos utilizando métodos estadísticos.

Aunque mi muestra no es representativa del ejército estadounidense (ni de sus ramas, como el ejército y la marina estadounidenses), es lo que los politólogos llaman una muestra de conveniencia. Esto ayuda a extraer ideas extremadamente raras sobre cómo los miembros del servicio pueden confiar en las tecnologías militares mejoradas por IA y el efecto de esta confianza en el carácter de la guerra.

Esta muestra también es una prueba difícil para mi comprensión de los posibles cambios en el futuro de la guerra dado el surgimiento de la IA, ya que sobremuestreé a oficiales de campo, incluidos mayores/tenientes comandantes, tenientes coroneles/comandantes y coroneles/capitanes. Tienen años de entrenamiento y son expertos en objetivos, y muchos se han desplegado para combatir y han tomado decisiones sobre drones. También están surgiendo líderes de alto nivel a quienes se les ha confiado la tarea de evaluar las implicaciones de las nuevas tecnologías para conflictos futuros. Estas características implican que los oficiales de mi muestra pueden estar predispuestos a desconfiar de las tecnologías militares mejoradas por IA más que otros segmentos del ejército, especialmente los oficiales subalternos a quienes a menudo se les llama » nativos digitales «.

La encuesta revela varios hallazgos clave. En primer lugar, los oficiales pueden confiar en las tecnologías militares mejoradas por IA de diferentes maneras, según la variación en el nivel de toma de decisiones y el tipo de supervisión de estas nuevas capacidades. Si bien los oficiales generalmente desconfían de los diferentes tipos de armas mejoradas por IA, confían menos en las capacidades utilizadas para la guerra única (toma de decisiones estratégicas con supervisión de máquinas). Por otro lado, demuestran más confianza en la guerra en mosaico (supervisión humana de la toma de decisiones estratégicas optimizada por IA). Esto muestra que los oficiales prefieren consistentemente el control humano de la IA para identificar patrones matizados en la actividad enemiga, generar opciones militares para presentar al adversario múltiples dilemas o ayudar a mantener la preparación para la guerra durante un conflicto prolongado.

En comparación con el grupo de referencia, la confianza de los oficiales en las tecnologías militares basadas en IA disminuye más en términos de guerra única (18,8 por ciento) que en la guerra en mosaico (10,5 por ciento); consulte la Figura 1 . Si bien las diferencias en los niveles medios de confianza de los oficiales en comparación con el grupo de referencia son estadísticamente significativas para ambos tipos de guerra mejorada por IA, son más pronunciadas para las nuevas capacidades militares utilizadas para la guerra única que para la guerra en mosaico. Además, el cambio promedio en la probabilidad de la confianza de los oficiales en ambos tipos de guerra mejorada con IA (es decir, el efecto marginal promedio de las tecnologías militares mejoradas con IA en la confianza de los oficiales) solo es estadísticamente significativo para la guerra única. En general, estos resultados sugieren que los oficiales desconfían menos de las tecnologías militares mejoradas con IA que se utilizan con supervisión humana para ayudar en la toma de decisiones en los niveles superiores.

Estos resultados para los niveles de confianza se reflejan en gran medida en las actitudes de apoyo de los agentes. Los oficiales demuestran menos apoyo a las tecnologías militares mejoradas con IA utilizadas para la guerra única en comparación con el grupo de referencia, y prácticamente en el mismo nivel (18,3 por ciento) y grado de significancia estadística. Sin embargo, en comparación con el grupo de referencia, los oficiales también apoyan la guerra con minotauros más que otros patrones de guerra mejorada por IA, con un cambio en el nivel de apoyo de alrededor del 6,5 por ciento. Esto sugiere que, si bien los oficiales pueden desconfiar menos de las tecnologías militares mejoradas con IA incorporadas en niveles más altos de toma de decisiones y con control humano, apoyan más las tecnologías militares mejoradas con IA utilizadas para la toma de decisiones a nivel táctico y con supervisión de máquinas. . En resumen, las actitudes de los oficiales parecen reflejar el argumento del profesor Kenneth Payne del King’s College de que «los robots de guerra serán combatientes increíbles, pero estrategas limitados».

Figura 1. Confianza y apoyo en relación con el grupo de referencia para los cuatro tipos de guerra basada en IA. Nota: Los valores representan cambios en los niveles de apoyo y confianza para las tecnologías militares mejoradas con IA por parte de los grupos de tratamiento en comparación con el grupo de referencia. Cuando los niveles de apoyo y confianza caen en comparación con el grupo de referencia, los valores son negativos. (Datos: Paul Lushenko. Visualización: François Diaz-Maurin)

El apoyo relativamente mayor de los oficiales al uso a nivel táctico de tecnologías militares mejoradas con IA revela un segundo hallazgo clave. Las actitudes de los oficiales hacia las tecnologías militares mejoradas por IA pueden ser más pronunciadas de apoyo que de confianza. Esto implica lo que algunos estudiosos llaman una » paradoja de la confianza «. Los oficiales parecen apoyar la adopción de nuevas tecnologías de campo de batalla mejoradas con IA, incluso si no necesariamente confían en ellas. Este fenómeno se relaciona principalmente con la guerra de minotauros (el uso de IA para la toma de decisiones a nivel táctico y con supervisión de máquinas). Esto sugiere que los oficiales esperan que las tecnologías militares mejoradas por IA colapsen el tiempo y el espacio de maniobra del adversario al tiempo que amplían el del ejército estadounidense, que se basa en una línea de tiempo acortada «del sensor al tirador» que los altos líderes militares creen que es el eje para derrotar . adversarios cercanos en conflictos futuros.

La variación en la magnitud del apoyo de los oficiales a las tecnologías militares mejoradas con IA utilizadas para la toma de decisiones a nivel táctico y con supervisión mecánica es mayor que los cambios en su confianza (Figura 2 ) . Además, los resultados muestran que la diferencia en las actitudes de confianza y apoyo de los oficiales es estadísticamente significativa: los oficiales apoyan las tecnologías militares mejoradas con IA utilizadas para la guerra de minotauros más de lo que confían en ellas. El cambio promedio en la probabilidad de que los oficiales apoyen las tecnologías militares mejoradas con IA utilizadas para la guerra de minotauros también es mayor que para los otros tres tipos de guerra mejorada con IA.

Combinados, estos resultados indican una desalineación de las creencias sobre el apoyo y la confianza de los oficiales estadounidenses hacia las tecnologías militares mejoradas por IA. A pesar de apoyar la adopción de tales tecnologías para optimizar la toma de decisiones en diversos niveles y grados de supervisión, los oficiales no confían en los tipos de guerra potenciales resultantes debido a las capacidades emergentes habilitadas por la IA. Este resultado sugiere que los oficiales estadounidenses pueden sentirse obligados a adoptar formas proyectadas de guerra que van en contra de sus propias preferencias y actitudes, especialmente la guerra con minotauros que es la base de los conceptos bélicos emergentes del Ejército y la Marina de los Estados Unidos .

Figura 2. Confianza y apoyo para los cuatro tipos de guerra basada en IA. Nota: Los valores representan niveles medios de apoyo y confianza para las tecnologías militares mejoradas con IA por parte de los grupos de tratamiento. (Datos: Paul Lushenko. Visualización: François Diaz-Maurin)

Otros factores explican aún más la variación en la confianza de los oficiales hacia las tecnologías militares mejoradas por IA. En mi encuesta, al controlar la variación en el nivel de toma de decisiones y el tipo de supervisión, encuentro que las actitudes de los oficiales frente a estas tecnologías también pueden estar determinadas por consideraciones morales, instrumentales y educativas subyacentes.

Los oficiales que creen que Estados Unidos tiene la obligación moral de utilizar tecnologías militares mejoradas con IA en el extranjero reflejan un mayor grado de confianza en estas nuevas capacidades en el campo de batalla, lo que también es consistente con actitudes de apoyo. Esto sugiere que las creencias morales de los oficiales sobre los beneficios potenciales de las tecnologías militares mejoradas con IA utilizadas en el extranjero, como durante las operaciones de asistencia humanitaria y socorro en casos de desastre, pueden ayudar a superar su desconfianza inherente en la adopción de estas capacidades.

Además, los oficiales que otorgan un valor instrumental a las tecnologías militares mejoradas con IA y experimentan una actitud de “miedo a perderse algo” hacia ellas, es decir, creen que la adopción de tales tecnologías por parte de otros países obliga a Estados Unidos a adoptarlas también, para que no está en desventaja en una posible carrera armamentista de IA—también tienden a tener una mayor confianza en estas capacidades emergentes. Se observan actitudes similares de confianza cuando se considera la educación. Los resultados muestran que la educación superior reduce la confianza de los oficiales en las tecnologías militares mejoradas con IA, lo que implica que un conocimiento mayor o más especializado plantea dudas sobre los méritos y límites de la IA durante la guerra futura. Finalmente, en la intersección de estas consideraciones normativas e instrumentales, encuentro que los oficiales que creen que la fuerza militar es necesaria para mantener el orden global también apoyan más el uso de tecnologías militares mejoradas por IA. En conjunto, estos resultados refuerzan investigaciones anteriores que muestran que las visiones del mundo de los oficiales moldean sus actitudes hacia las tecnologías del campo de batalla y que los oficiales pueden integrar diferentes lógicas al evaluar su confianza y apoyo al uso de la fuerza en el extranjero.

Cómo preparar mejor a los oficiales para la guerra basada en IA

Esta primera evidencia sobre las actitudes de los oficiales militares estadounidenses hacia la IA pinta un panorama más complicado de la evolución del carácter de la guerra debido a las tecnologías emergentes de lo que algunos analistas permiten. Sin embargo, estas actitudes tienen implicaciones para la modernización y las políticas bélicas y para la educación militar profesional de los oficiales, incluida la gobernanza de las armas nucleares.

En primer lugar, aunque algunos líderes militares estadounidenses afirman que “estamos siendo testigos de un cambio sísmico en el carácter de la guerra, impulsado nuevamente en gran medida por la tecnología”, el surgimiento de tecnologías militares mejoradas por IA en los conflictos puede constituir más una evolución que una revolución . Si bien las guerras en Gaza y Ucrania sugieren cambios importantes en la forma en que luchan los militares, también reflejan continuidades clave . Tradicionalmente, los militares han buscado capitalizar las nuevas tecnologías para mejorar su inteligencia, proteger sus fuerzas y ampliar el alcance de su fuego táctico y operativo, que se combinan para producir una “ asimetría radical ” en el campo de batalla. Más recientemente, se ha demostrado que los cambios en la forma en que los países utilizan y restringen los drones también moldean las percepciones públicas sobre el uso legítimo (o ilegítimo ) de la fuerza, un resultado consistente con las tecnologías militares emergentes totalmente autónomas.

Sin embargo, las implicaciones de estas y otras capacidades para los resultados estratégicos en la guerra son, en el mejor de los casos, dudosas . El éxito estratégico durante la guerra sigue siendo una función de la voluntad de los países de sacrificar las vidas de los soldados y el dinero de los contribuyentes para lograr objetivos políticos y militares que apoyen intereses nacionales vitales. De hecho, es posible que los oficiales de mi estudio hayan apoyado más las tecnologías militares mejoradas con IA utilizadas para la guerra de minotauros. Pero los participantes del estudio todavía demostraron mucha menos confianza y apoyo a las nuevas tecnologías del campo de batalla en general de lo que se podría esperar dada la exageración (si no la hipérbole y el miedo ) que rodea a su innovación militar. Estos resultados sugieren que los líderes militares deberían moderar sus expectativas con respecto a las implicaciones paradigmáticas de la IA para conflictos futuros. En otras palabras , deberíamos “prepararnos para sentirnos decepcionados por la IA”. La falta de una perspectiva tan lúcida permite, según el teniente coronel del ejército estadounidense Michael Ferguson, el surgimiento de “teorías de moda que transforman la guerra en un kabuki de eufemismos” y oscurecen las duras realidades del combate. Es un choque de voluntades, intensamente humano y condicionado por objetivos políticos.

En segundo lugar, las actitudes de confianza de los oficiales hacia las tecnologías militares mejoradas por IA son más complejas de lo que muestra mi estudio. De hecho, como señala un ex coronel de la Fuerza Aérea de EE. UU. y actualmente analista de la dirección del Estado Mayor Conjunto J-8 , es “difícil para los operadores predecir con un alto grado de probabilidad cómo podría funcionar realmente un sistema contra un adversario adaptable, lo que podría erosionar la confianza”. en el sistema.» En otro estudio en curso, encuentro que la confianza de los oficiales en las tecnologías militares mejoradas por IA puede depender de un conjunto complejo de consideraciones. Entre ellas se incluyen especificaciones técnicas, es decir, su finalidad no letal, mayor precisión y supervisión humana; efectividad percibida en términos de protección civil, protección de la fuerza y cumplimiento de la misión; y supervisión, incluida la regulación tanto nacional como especialmente internacional. De hecho, un oficial en este estudio señaló que la confianza en las tecnologías militares mejoradas con IA se basaba en “el cumplimiento de las leyes internacionales en lugar de las leyes nacionales de Estados Unidos”.

Estos resultados sugieren la necesidad de realizar más pruebas y experimentación de capacidades novedosas para alinear su uso con las expectativas de los miembros del servicio. Los formuladores de políticas y los líderes militares también deben aclarar los conceptos de guerra dentro de los cuales se debe fomentar el desarrollo de tecnologías militares mejoradas con IA; la doctrina que guía su integración en diferentes ámbitos, en diferentes niveles y con diferentes propósitos; y las políticas que rigen su uso. Para esta última tarea, los funcionarios deben explicar cómo la política estadounidense coincide con (o diverge) las leyes internacionales, así como qué normas condicionan el uso de tecnologías militares mejoradas con IA, considerando cómo los oficiales en los rangos de campo, al menos, esperan estas capacidades para ser utilizadas. Para llenar este vacío, la Casa Blanca anunció recientemente una política estadounidense sobre el uso militar responsable de la IA y funciones y sistemas autónomos, el Departamento de Defensa adoptó una directiva que rige el desarrollo y uso de armas autónomas en el ejército estadounidense, y el Pentágono también creó la Oficina Principal de Inteligencia Digital y Artificial para ayudar a hacer cumplir esta directiva, aunque, según se informa, esta oficina está plagada de desafíos presupuestarios y de personal.

Finalmente, los líderes militares también deberían renovar la educación militar profesional para instruir a los oficiales sobre los méritos y límites de la IA. Deberían explorar la aplicación de la IA en otros contextos estratégicos, incluido el mando y control nuclear. Muchas iniciativas en el ejército estadounidense ya reflejan esta necesidad, especialmente dada la vacilación de los oficiales a la hora de asociarse con capacidades habilitadas por IA.

Operacionalmente, el “ Proyecto Ridgeway ”, dirigido por el 18.º Cuerpo Aerotransportado del Ejército de EE. UU., está diseñado para integrar la IA en el proceso de selección de objetivos. Esto es igualado por “ Amelia ” y “Loyal Wingman”, que son programas de la Armada y la Fuerza Aérea diseñados para optimizar los procesos del personal y la lucha. Institucionalmente, además de los cursos de certificación preexistentes , algunos analistas fomentan la integración de evaluaciones de alfabetización de datos en programas de evaluación basados en talentos, como el Programa de Evaluación de Comandantes del Ejército de EE. UU. Desde el punto de vista educativo, las academias de servicio y las escuelas de guerra cuentan con profesores, centros de investigación y asignaturas optativas dedicadas a estudiar las implicaciones de la IA para la guerra futura. La Escuela de Guerra del Ejército de EE. UU. contrató recientemente a un profesor de ciencia de datos, la Academia Naval de EE. UU. mantiene un grupo de investigación sobre “Armas, robótica e ingeniería de control” y la Escuela de Guerra Naval de EE. UU. ofrece una materia optativa de “IA para líderes estratégicos” .

El MQ-9 Reaper, visto aquí disparando un misil aire-tierra-114 Hellfire, es un avión sin piloto controlado remotamente que puede usarse para inteligencia, reconocimiento y ataques. (Foto: Fuerza Aérea de EE.UU. Diseño: François Diaz-Maurin)

Al mismo tiempo, los juegos de guerra realizados en la Escuela de Guerra Naval de EE. UU. y en otros lugares sugieren que las capacidades cibernéticas pueden fomentar la automatización y la delegación previa del mando y control nuclear a niveles de mando tácticos e incentivar estrategias agresivas de contrafuerza. Pero mis resultados sugieren un resultado desconcertante que merece muchas más pruebas. Tomados al pie de la letra, y a pesar de que los resultados podrían ser los mismos que los del uso de armas nucleares en la guerra, los resultados plantean una pregunta inquietante: ¿Estarían realmente dispuestos los oficiales a apoyar una posible automatización y predelegación del mando y control nuclear a ¿La IA a nivel táctico, incluso si no confían en ella o no confían o apoyan el uso de la IA para gobernar estrategias de contrafuerza, como sugieren mis resultados?

Si bien esta conclusión puede parecer descabellada (contradice un conjunto de investigaciones sobre el “ tabú ” nuclear, la escalada de la crisis y la autoridad presidencial exclusiva para el uso de estas armas), las amenazas de Rusia de utilizar armas nucleares en Ucrania han alentado al ejército estadounidense a reconsiderar la posibilidad. del uso limitado de armas nucleares durante la guerra entre grandes potencias. A pesar del aterrador potencial de este escenario de “regreso al futuro”, que se hace eco de la proliferación de armas nucleares tácticas durante la Guerra Fría, o debido a él, las escuelas de guerra estadounidenses han revitalizado la educación para la preparación operativa durante un intercambio nuclear táctico entre países involucrados en grandes conflictos . conflicto de escala.

Sin embargo, no está claro hasta qué punto estas y otras iniciativas están educando efectivamente a los oficiales sobre la IA. Parte del problema es que las iniciativas enfrentan enfoques pedagógicos opuestos entre sí. Algunos programas analizan la alfabetización en datos y la IA con un enfoque de “un kilómetro de ancho, un centímetro de profundidad” que integra una sola lección en un curso de un plan de estudios más amplio. Otros programas brindan mayores oportunidades de desarrollo y un enfoque “más limitado y profundo”, en el que un puñado de oficiales seleccionan voluntariamente materias optativas que se suman a un plan de estudios más amplio. Otros programas, como el de la Escuela de Guerra del Ejército de EE. UU., intentan el enfoque del “hilo dorado”, que incorpora la alfabetización en datos y la inteligencia artificial en cursos que enmarcan un plan de instrucción más amplio. Sin embargo, este último enfoque obliga a los administradores a hacer concesiones importantes en términos de contenido y tiempo y supone una profunda experiencia del profesorado.

En el futuro, el Estado Mayor Conjunto J-7 —la dirección responsable de coordinar el entrenamiento y la educación en toda la fuerza conjunta de EE. UU.— debería conceptualizar la educación militar profesional como un continuo de enriquecimiento sostenido y aditivo a lo largo del tiempo en términos de alfabetización en datos e instrucción en IA. Los estudiantes precomisionados que asisten a las academias de servicio o participan en el Cuerpo de Entrenamiento de Oficiales de Reserva deben estar expuestos a conceptos fundamentales sobre la IA. Los oficiales de grado junior y medio deben integrar estos conocimientos durante el entrenamiento, los despliegues y mientras asisten a la educación de nivel intermedio, como la Escuela de Comando y Estado Mayor del Ejército de EE. UU. Al ser seleccionados para las escuelas de guerra, los oficiales deben luchar con consideraciones conceptuales, normativas e instrumentales que rigen el uso de la IA en combate, que según mi estudio pueden moldear las actitudes militares hacia las tecnologías novedosas.

Por supuesto, adoptar este enfoque educativo integral requerirá tiempo y dinero. También está sujeto a las prerrogativas de diferentes partes interesadas, culturas de servicio y rivalidades entre servicios . Sin embargo, al alinear la capacitación y la educación con resultados de aprendizaje claros y factibles, este modelo de instrucción holístico aprovecha las oportunidades existentes para garantizar que el ejército estadounidense esté listo y dispuesto a adoptar tecnologías militares mejoradas con IA durante tiempos de paz y guerras futuras de manera que se alineen con las normas internacionales. leyes y normas que regulan su uso legítimo.

Paul Lushenko es teniente coronel del ejército de EE. UU., director de operaciones especiales e instructor de la facultad de la Escuela de Guerra del Ejército de EE. UU. Es coeditor de Drones and Global Order: Implications of Remote Warfare for International Society (Routledge, 2022) y coautor de The Legitimacy of Drone Warfare: Evaluating Public Perceptions (Routledge, 2024). Recibió su doctorado en relaciones internacionales de la Universidad de Cornell.

Artículo publicado originalmente ayer 29 de Noviembre de 2023 en el Boletín de los Científicos Atómicos de los Estados Unidos. Gaceta Crítica.

Deja un comentario